Una gran mayoría del público en ocho países analizados por The Reuters Institute coincide en que las plataformas tecnológicas, y no los gobiernos, deben definir y aplicar sus propias políticas de contenido, y les exige hacer mucho más para frenar la desinformación e incluso asumir responsabilidad por su difusión.

El informe, basado en muestras representativas de personas encuestadas en EU, Reino Unido, Alemania, Brasil, España, Argentina, Japón y Corea del Sur, indica que la gente quiere que las empresas como Meta, X (antes Twitter), Google o TikTok se hagan responsables de lo que permiten o no en sus plataformas, sin que sean los políticos quienes dicten esas decisiones.

Uno de los hallazgos más relevantes es que esta visión no varía drásticamente entre países, edades, ideologías políticas ni niveles educativos. Incluso en naciones con antecedentes regulatorios más estrictos como Alemania o Reino Unido, el consenso considera que la autorregulación es preferida frente a la intervención gubernamental.

Piden más acciones de las plataformas en frenar la desinformación

Aunque las personas desean que las plataformas mantengan el control sobre sus políticas de contenido, también exigen que estas hagan mucho más para frenar la desinformación y las noticias falsas. Casos recientes en EU, Brasil y Reino Unido han demostrado el impacto real de la desinformación viral en procesos electorales, seguridad pública y tensiones sociales.

El estudio subraya que los usuarios esperan que empresas como Meta, Google y TikTok desarrollen mecanismos robustos para identificar y limitar la propagación de contenido falso, ya sea con inteligencia artificial, etiquetas, verificadores independientes o herramientas de moderación comunitaria como “Notas de la Comunidad” en X.

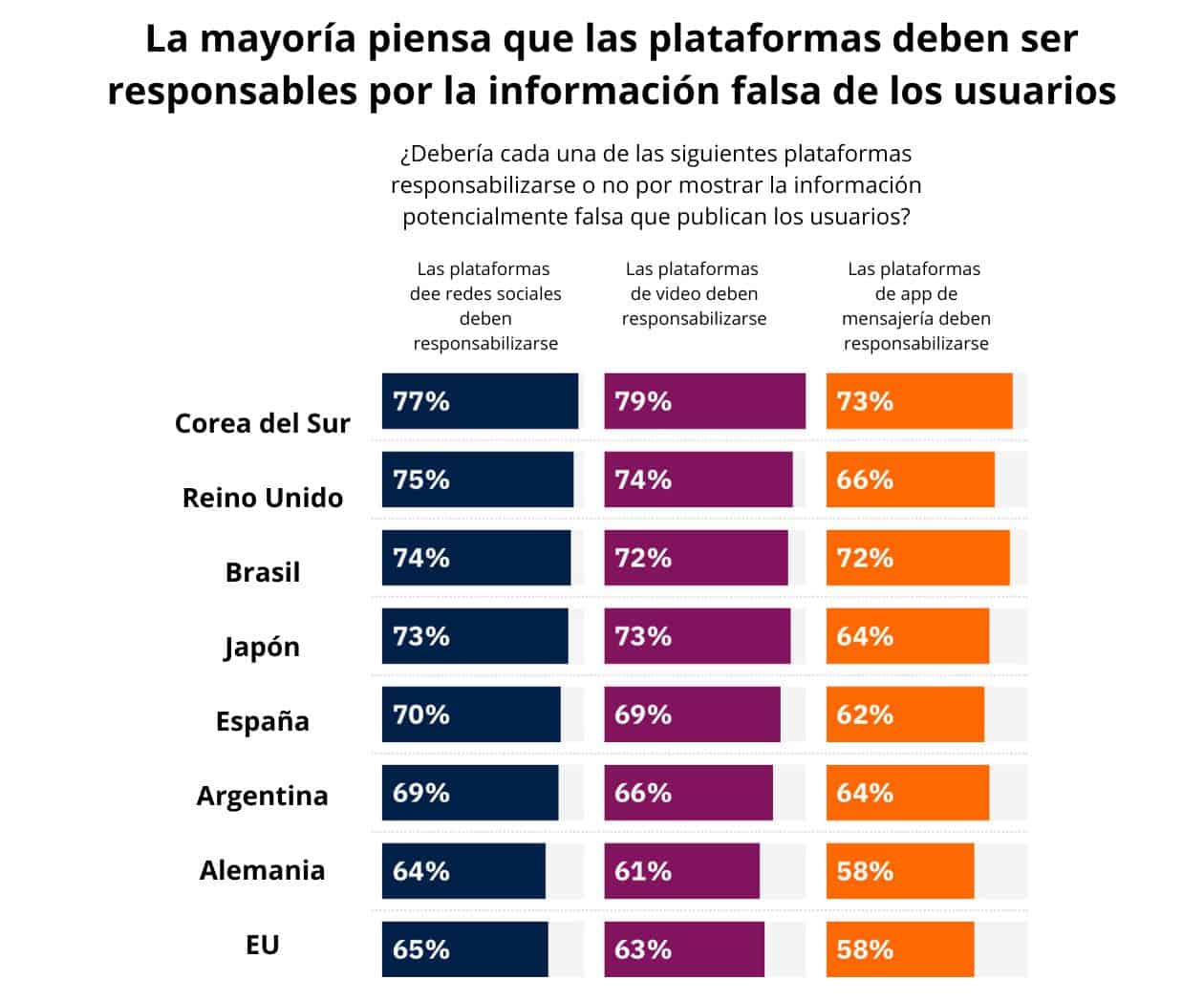

Además, la mayoría de los entrevistados de todos los países piensan que las plataformas deberían ser responsables de la información falsa publicada por los usuarios.

Esta pregunta ha sido un tema particularmente polémico en los Estados Unidos, donde la Sección 230 de la Ley de Decencia de las Comunicaciones otorga a las plataformas en línea una amplia inmunidad de responsabilidad por el contenido publicado por los usuarios, quienes son responsables de lo que publican.

En cambio, en otros países, se han tomado medidas activas para explorar cómo las plataformas en línea pueden ser más responsables del contenido publicado por los usuarios.

La única área donde se percibe un mayor apetito por la intervención gubernamental es en torno a las herramientas de inteligencia artificial generativa, como ChatGPT, Gemini o Grok.

Los usuarios expresan incertidumbre sobre su potencial para difundir desinformación sofisticada como deepfakes, y temen que su impacto pueda superar la capacidad de las plataformas para autorregularse.

En países como Reino Unido y Alemania, hasta un 50% de los encuestados apoya una mayor supervisión estatal sobre este tipo de tecnologías emergentes.

El estudio del Reuters Institute hace un llamado a gobiernos, plataformas y actores civiles a incorporar activamente la opinión pública en el diseño de políticas de contenido.